반응형

5.11 일 LG 틔운 미니에서 청경채 + 쌈추 인스톨

- 씨앗: LG틔운용 쌈추,청경채 씨앗

쌈추 씨앗은 초록색 코팅된 느낌의 동글동글한 씨앗이다.

청경채는 보라색 코팅되어 있는듯한 동글동글한 씨앗이다.

핀셋으로 4알씩 하나의 구멍에 넣어주고

틔운 미니에 물을 채우고, 식물 영양제 A,B를 섞어 준다.

그리고 키트를 장착해주고, 조명 시간등을 조정해 주면 된다.

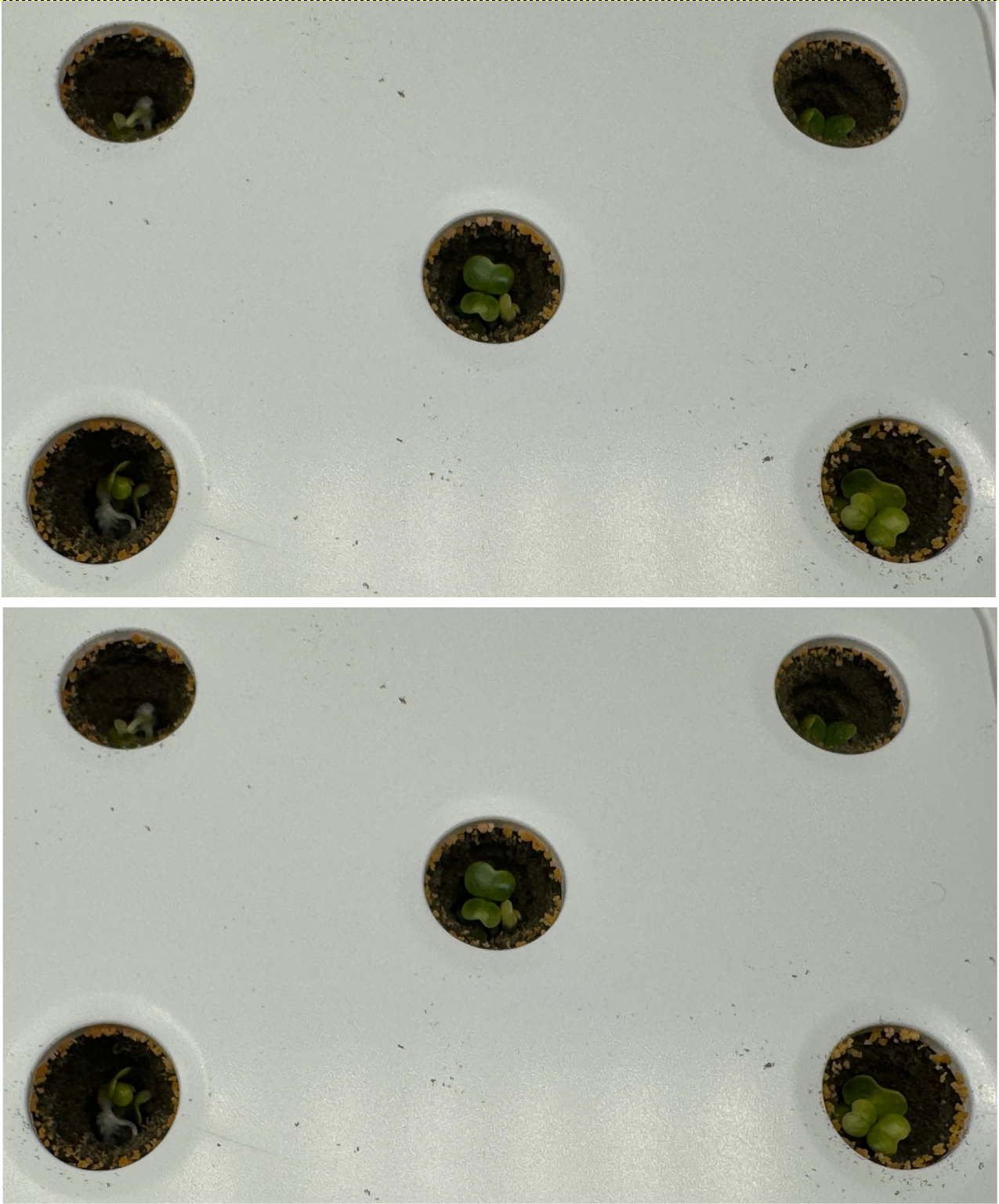

1일차.

껍질이 깨지면서 싹이 나려고 함..

2일차

반응형